Kubernetes学习手札-kubernetes集群环境搭建(kubeadm 方式)

2.1 前置知识点

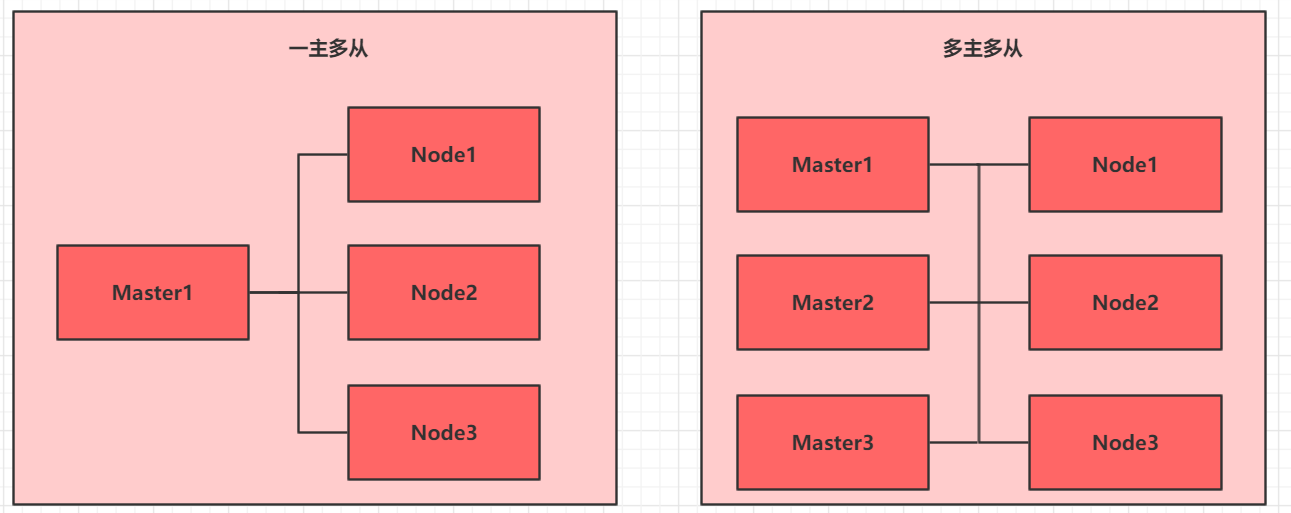

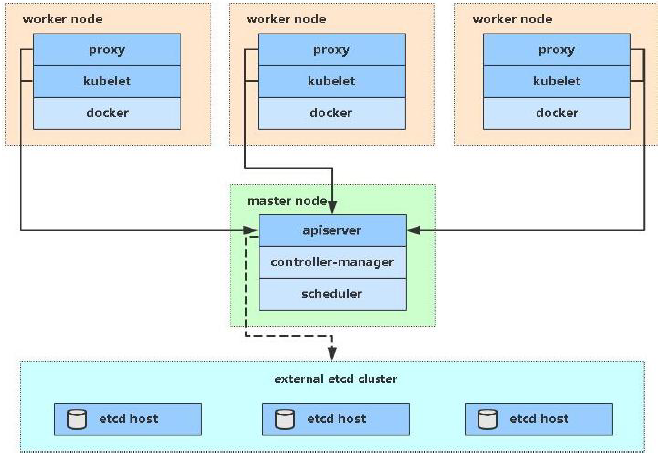

目前生产部署Kubernetes 集群主要有两种方式:

kubeadm

Kubeadm 是一个K8s 部署工具,提供kubeadm init 和kubeadm join,用于快速部署Kubernetes 集群。

官方地址:https://kubernetes.io/docs/reference/setup-tools/kubeadm/kubeadm/

二进制包

从github 下载发行版的二进制包,手动部署每个组件,组成Kubernetes 集群。

Kubeadm 降低部署门槛,但屏蔽了很多细节,遇到问题很难排查。如果想更容易可控,推荐使用二进制包部署Kubernetes 集群,虽然手动部署麻烦点,期间可以学习很多工作原理,也利于后期维护。

2.2 kubeadm 部署方式介绍

kubeadm 是官方社区推出的一个用于快速部署kubernetes 集群的工具,这个工具能通过两条指令完成一个kubernetes 集群的部署:

- 创建一个Master 节点kubeadm init

- 将Node 节点加入到当前集群中$ kubeadm join

2.3 安装要求

在开始之前,部署Kubernetes 集群机器需要满足以下几个条件:

- 一台或多台机器,操作系统CentOS7.x-86_x64

- 硬件配置:2GB 或更多RAM,2 个CPU 或更多CPU,硬盘30GB 或更多

- 集群中所有机器之间网络互通

- 可以访问外网,需要拉取镜像

- 禁止swap 分区

2.4 最终目标

- 在所有节点上安装Docker 和kubeadm

- 部署Kubernetes Master

- 部署容器网络插件

- 部署Kubernetes Node,将节点加入Kubernetes 集群中

- 部署Dashboard Web 页面,可视化查看Kubernetes 资源

2.5 准备环境

| 角色 | IP地址 | 组件 |

|---|---|---|

| k8s-master01 | 192.168.1.88 | docker,kubectl,kubeadm,kubelet |

| k8s-node01 | 192.168.1.33 | docker,kubectl,kubeadm,kubelet |

| k8s-node02 | 192.168.1.34 | docker,kubectl,kubeadm,kubelet |

2.6 系统初始化

2.6.1 设置系统主机名以及 Host 文件的相互解析

hostnamectl set-hostname k8s-master01 && bash

hostnamectl set-hostname k8s-node01 && bash

hostnamectl set-hostname k8s-node02 && bash

cat <<EOF>> /etc/hosts

192.168.1.88 k8s-master01

192.168.1.33 k8s-node01

192.168.1.34 k8s-node02

EOF

scp /etc/hosts root@192.168.1.33:/etc/hosts

scp /etc/hosts root@192.168.1.34:/etc/hosts

2.6.2 安装依赖文件(所有节点都要操作)

yum install -y conntrack ntpdate ntp ipvsadm ipset jq iptables curl sysstat libseccomp wget vim net-tools git

2.6.3 设置防火墙为 Iptables 并设置空规则(所有节点都要操作)

systemctl stop firewalld && systemctl disable firewalld

yum -y install iptables-services && systemctl start iptables && systemctl enable iptables && iptables -F && service iptables save

2.6.4 关闭 SELINUX和关闭虚拟空间(所有节点都要操作)

swapoff -a && sed -i '/ swap / s/^\(.*\)$/#\1/g' /etc/fstab

setenforce 0 && sed -i 's/^SELINUX=.*/SELINUX=disabled/' /etc/selinux/config

2.6.5 调整内核参数,对于 K8S(所有节点都要操作)

cat <<EOF> kubernetes.conf

net.bridge.bridge-nf-call-iptables=1

net.bridge.bridge-nf-call-ip6tables=1

net.ipv4.ip_forward=1

net.ipv4.tcp_tw_recycle=0

vm.swappiness=0 # 禁止使用 swap 空间,只有当系统 OOM 时才允许使用它

vm.overcommit_memory=1 # 不检查物理内存是否够用

vm.panic_on_oom=0 # 开启 OOM

fs.inotify.max_user_instances=8192

fs.inotify.max_user_watches=1048576

fs.file-max=52706963

fs.nr_open=52706963

net.ipv6.conf.all.disable_ipv6=1

net.netfilter.nf_conntrack_max=2310720

EOF

cp kubernetes.conf /etc/sysctl.d/kubernetes.conf

# 重新刷新配置

sysctl -p /etc/sysctl.d/kubernetes.conf

# 加载网桥过滤模块

modprobe br_netfilter

# 查看网桥过滤模块是否成功加载

lsmod | grep br_netfilter

2.6.6 调整系统时区(所有节点都要操作)–可省略

# 设置系统时区为 中国/上海

timedatectl set-timezone Asia/Shanghai

# 将当前的 UTC 时间写入硬件时钟

timedatectl set-local-rtc 0

# 重启依赖于系统时间的服务

systemctl restart rsyslog

systemctl restart crond

还有时间同步 ntpq 或者 chronyd

2.6.7 设置 rsyslogd 和 systemd journald(所有节点都要操作)–可省略

# 持久化保存日志的目录

mkdir /var/log/journal

mkdir /etc/systemd/journald.conf.d

cat > /etc/systemd/journald.conf.d/99-prophet.conf <<EOF

[Journal]

# 持久化保存到磁盘

Storage=persistent

# 压缩历史日志

Compress=yes

SyncIntervalSec=5m

RateLimitInterval=30s

RateLimitBurst=1000

# 最大占用空间 10G

SystemMaxUse=10G

# 单日志文件最大 200M

SystemMaxFileSize=200M

# 日志保存时间 2 周

MaxRetentionSec=2week

# 不将日志转发到 syslog

ForwardToSyslog=no

EOF

systemctl restart systemd-journald

2.6.8 kube-proxy开启ipvs的前置条件(所有节点都要操作)

yum install ipvsadm ipset -y

cat <<EOF> /etc/sysconfig/modules/ipvs.modules

#!/bin/bash

modprobe -- ip_vs

modprobe -- ip_vs_rr

modprobe -- ip_vs_wrr

modprobe -- ip_vs_sh

modprobe -- nf_conntrack_ipv4

EOF

chmod 755 /etc/sysconfig/modules/ipvs.modules && bash /etc/sysconfig/modules/ipvs.modules && lsmod | grep -e ip_vs -e nf_conntrack_ipv4

2.6.9 安装 Docker 软件(所有节点都要操作)

也可参考Centos 安装Docker(含在线和离线):https://199604.com/2011 比较全,这里就快速部署

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum install -y docker-ce

## 创建 /etc/docker 目录

mkdir /etc/docker

cat > /etc/docker/daemon.json <<EOF

{

"exec-opts": ["native.cgroupdriver=systemd"],

#"log-driver": "json-file",

#"log-opts": {

# "max-size": "100m"

#}

}

EOF

mkdir -p /etc/systemd/system/docker.service.d

# 重启docker服务

systemctl daemon-reload && systemctl restart docker && systemctl enable docker

上传文件到

“` /etc/yum.repos.d/ “`目录下,也可以 代替 “` yum-config-manager –add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo “` 命令

.6.10 安装 Kubeadm (所有节点都要操作)

cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=http://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=http://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

http://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

# 安装并且自启动

yum install -y kubelet kubeadm kubectl

# 设置kubelet开机自启

# systemctl enable kubelet

# 配置kubelet的cgroup

# 修改 /etc/sysconfig/kubelet 添加下面:

KUBELET_CGROUP_ARGS="--cgroup-driver=systemd"

KUBE_PROXY_MODE="ipvs"

# 该选项用来忽略swap报警,关闭swap后也可以不用修改

KUBELET_EXTRA_ARGS="--fail-swap-on=false"

2.7 部署Kubernetes Master

.7.1 初始化主节点(主节点操作)

下面的操作只需要在master节点上执行即可

kubeadm init \

--apiserver-advertise-address=192.168.1.88 \

#--kubernetes-version v1.21.1 \

--pod-network-cidr=10.244.0.0/16 \

--service-cidr=10.96.0.0/12 \

--image-repository registry.aliyuncs.com/google_containers \

--ignore-preflight-errors=Swap

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

出现以下就是成功了:

Your Kubernetes control-plane has initialized successfully!

To start using your cluster, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

Alternatively, if you are the root user, you can run:

export KUBECONFIG=/etc/kubernetes/admin.conf

You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/

Then you can join any number of worker nodes by running the following on each as root:

kubeadm join 192.168.1.88:6443 --token 2pmrm0.u1e5gh9ig8hd8hp2 \

--discovery-token-ca-cert-hash sha256:47802b012887c7289a32e69a6d6eb6ca710e647ab6427457de1363035c44c001

.7.2 加入主节点以及其余工作节点

kubeadm join 192.168.1.88:6443 --token 2pmrm0.u1e5gh9ig8hd8hp2 \

--discovery-token-ca-cert-hash sha256:47802b012887c7289a32e69a6d6eb6ca710e647ab6427457de1363035c44c001

2.7.3 部署网络插件

只需要在master节点上执行即可

关于 http://quay.io 可用源很少,目前有如下镜像站

- http://quay-mirror.qiniu.com (七牛云, 推荐, 但没有找到长期支持的声明)

- http://quay.mirrors.ustc.edu.cn (中科大, 经常不可用, 不推荐)

wget https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

# 修改文件中quay.io仓库为 quay-mirror.qiniu.com

kubectl apply -f kube-flannel.yml

# kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

# 查看集群状态

kubectl get nodes

如果你的集群安装过程中遇到了其他问题,我们可以使⽤下⾯的命令来进⾏重置:

#在master节点之外的节点进行操作

kubeadm reset

systemctl stop kubelet

systemctl stop docker

rm -rf /var/lib/cni/

rm -rf /var/lib/kubelet/*

rm -rf /etc/cni/

ifconfig cni0 down

ifconfig flannel.1 down

ifconfig docker0 down

ip link delete cni0

ip link delete flannel.1

##重启kubelet

systemctl restart kubelet

##重启docker

systemctl restart docker

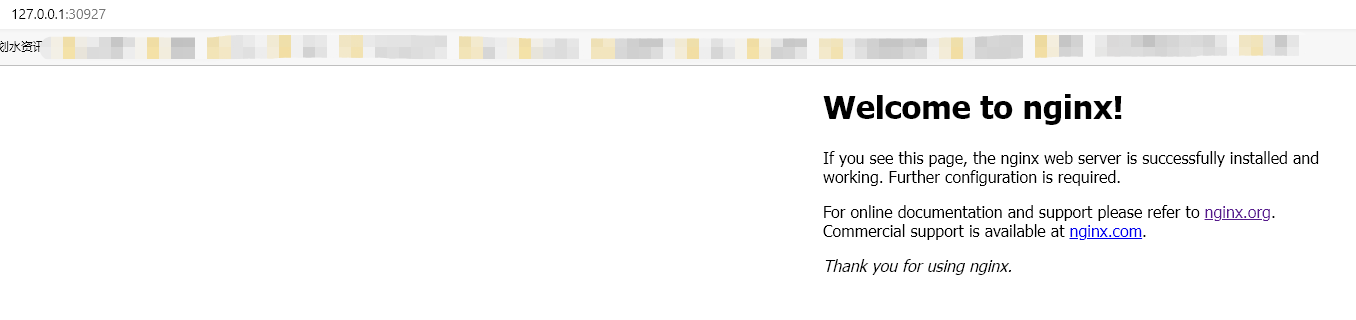

2.8 测试kubernetes 集群-master运行

2.8.1 部署nginx 测试

# 创建一个nginx服务

kubectl create deployment nginx --image=nginx

# 暴露端口

kubectl expose deployment nginx --port=80 --type=NodePort

# 查看服务状态

kubectl get pod,svc

2.9 kubectl 命令自动补全

yum install -y bash-completion

source /usr/share/bash-completion/bash_completion

source <(kubectl completion bash)

#/root/.bashrc 加2行代码 ,方便以后每次登录自动生效:

source /usr/share/bash-completion/bash_completion

source <(kubectl completion bash)